Zweierkomplement

Das Zweierkomplement ist eine Möglichkeit, negative Zahlen binär darzustellen ohne dafür ein besonderes Vorzeichen wie + oder - zu benötigen. Mithilfe des Zweierkomplements können nicht nur negative Zahlen beschrieben werden, sondern damit kann auch die Subtraktion als Addition umgesetzt werden, was den Aufbau von Rechenwerken erheblich vereinfacht.

Mathematische Grundlage

Die Grundidee ist, dass man für alle Zahlen eine feste Länge annimmt und das erste Bit als Vorzeichenbit betrachtet. Üblicherweise wird 0 als positives und 1 als negatives Vorzeichen verwendet.

Bei 4 Bit langen Zahlen ist also die größte positive Zahl und die Zahlen sind negativ, wobei und . Warum das so ist, wird im Folgenden erklärt:

Nehmen wir die Zahl . Wenn wir zu dieser Zahl 1 hinzuaddieren würde, erhielten wir das Ergebnis . Da wir eine feste Länge von 4 Bits für unsere Zahlen gesetzt haben, fällt die führende 1 weg und als Ergebnis bleibt übrig – genau das Ergebnis, das wir uns wünschen.

Um diese Eigenschaft für alle negativen Zahlen zu erhalten, müssen darum die negativen Zahlen von bis wachsen.

Um das Vorzeichen einer beliebigen Zahl zu ändern (egal, ob von nach oder umgekehrt) nehme man die Zahl, invertiere alle Bits (aus 0en werden 1en und umgekehrt) und addiere dann 1[1].

Wir bleiben bei 4 Bit langen Zahlen und nehmen als Beispiel. Diese wird nun wie folgt in ihr negatives Gegenstück umgewandelt:

- Invertiere alle Bits:

- Addiere 1:

Die Zweierkomplement-Darstellung von ist also

Allgemein können mit Bits die Zahlen von bis dargestellt werden.

Vorteile dieser Darstellung

Die Darstellung von negativen Zahlen mit dem Zweierkomplement bietet viele Vorteile. Mithilfe des Vorzeichenbits kann extrem schnell geprüft werden, ob eine Zahl positiv oder negativ ist. Auch die Information, ob eine Zahl gerade oder ungerade ist, bleibt am letzten Bit erkennbar. Nicht zuletzt kann das Zweierkomplement genutzt werden, um die Subtraktion von zwei binären Zahlen als Addition umzusetzen. Auf diese Weise können Prozessoren einfacher gestaltet werden und müssen weniger unterschiedliche Anweisungen ausführen können.

Auswirkungen beim Programmieren

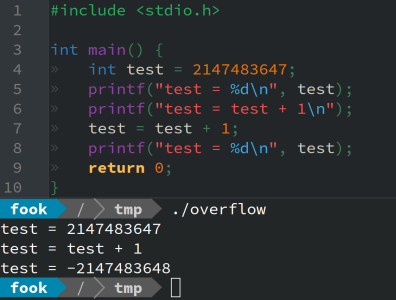

In modernen Computern werden typischerweise 32 oder 64 Bit als Wortlänge verwendet. Beim Programmieren hängt die Wortlänge oft vom verwendeten Datentyp ab. Zum Beispiel ist der Datentyp int für Ganzzahlen typischerweise 32 Bit lang. Wenn 1 Bit für das Vorzeichen reserviert ist, bleiben noch 31 Bits für die eigentliche Zahl übrig. Die größte Zahl, die man mit einem int darstellen kann, ist also . Was passieren kann, wenn man zu dieser Zahl 1 hinzuzuaddieren versucht, zeigen die beiden folgenden Abbildungen:

- Das oben abgebildete Programm ist in C geschrieben und addiert zum größtmöglichen Integerwert 1 hinzu. In dem Terminal unten ist die Ausgabe des Programms zu sehen.

-

2147483647 + 1 = -2147483648?!

-

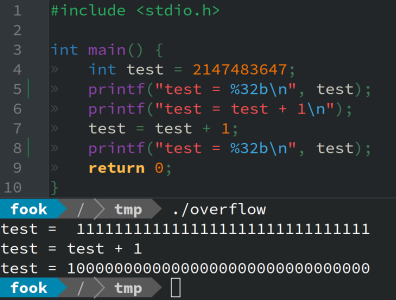

In der Binärdarstellung lässt sich leichter nachvollziehen, was da passiert.

Manche Programmiersprachen wie C produzieren bei derartigen Rechenoperationen keine Fehlermeldung oder Warnung. In anderen Sprachen wie JavaScript wird Infinity als Ergebnis ausgegeben, wenn Zahlen zu groß werden. In wieder anderen Sprachen wie Python gibt es so gut wie keine Einschränkungen für die Größe von Zahlen.

Weblinks

Fußnoten

- ↑ Wenn man nicht 1 addiert, kann man zwar immer noch jeder positiven Zahl ein negatives Gegenstück zuweisen und umgekehrt, aber dann gibt es zwei Darstellungen für die 0, nämlich und und das bringt wieder neue Probleme mit sich.